עליית המכונות 20

מיוחד: המודל הסיני החדש, למה זה משנה את הכל

שלום, ברוכים הבאים לגליון 20!

אם אתם קוראים את זה באפליקציה, כנראה שהעברית מבולגנת והכל כתוב בפונט משונה. עדיף לקרוא את גירסת הדפדפן המסודרת יותר כאן.

היום גליון מיוחד ספיישל שכולו מוקדש למודל הסיני החדש R1 של חברת Deepseek.

מעניין? ספרו לחברים על הניוזלטר:

https://rotm.co.il

נשיקות

-מתי

נו תסביר מה קורה

חברה סינית בשם Deepseek הוציאה מודל חדש שנקרא R1, שהוא כמעט ברמה של מודל הדגל של OpenAI. אפשר לשחק איתו בחינם באתר שלהם. המודל נמסר לכולם בקוד פתוח נדיב ביותר, כולל הסברים יפים על איך זה עובד: קחו ותפעילו בבית כמה שאתם רוצים.

בסדר, על זה ניוזלטר שלם? כן. תקראו ותראו.

המודל שייך למשפחה החדשה של מנועי השפה (ש-OpenAI היתה החלוצה שלהם, עם סדרת ה-”o” למיניהם) שיודעים לחשוב לפני שהם נותנים תשובה סופית. עד לא מזמן, היינו שואלים שאלה והמודל היה רץ מיד לתת את התשובה הראשונה שעולה לו בראש. אבל החדשים יודעים להתפלפל על מספר תשובות, לפרק את הבעייה לחלקים, לחזור אחורה קצת, לחשוב שוב. ככה, התשובות שלהם טובות יותר, ואם נותנים להם מספיק זמן ומשאבים הם יכולים לענות על שאלות קשות ומורכבות שנחשבו לבלתי אפשריות עבור מודל שפה עד לא מזמן.

הוא זול מאוד

הוי! מרגיז ומעליב כמה שהוא זול. הסינים השכיבו $5.5 מליון כדי לאמן אותו (ועוד סכום דומה כדי לאמן את האבא שלו, ראו בהמשך). אם אתם רוצים לעשות גם, המספר הזה לא רלבנטי עבורכם: צריך להוסיף את המחיר של הצוות, הטעויות שתעשו בדרך, זמן המחשב שתבזבזו סתם ועוד ועוד. אבל יחסית לכסף שמטא ו-OpenAI מדווחות עליו, זה מחיר מצחיק ממש, בין עשירית למאית (תלוי איך סופרים ולפי מה, קשה לדעת בדיוק).

גם להפעיל אותו זול מאוד - תכלס בחינם אצלם באתר, ולשימושים תעשייתיים תקבלו אותו ביותר מ-90% הנחה מול OpenAI! וכאמור, אם רק רוצים, אפשר להתקין אותו אצלכם (בגרסאות הזעירות שלו הוא יכול לרוץ על המק החדש שלכם, אבל אלה לא הגרסאות החכמות ממש).

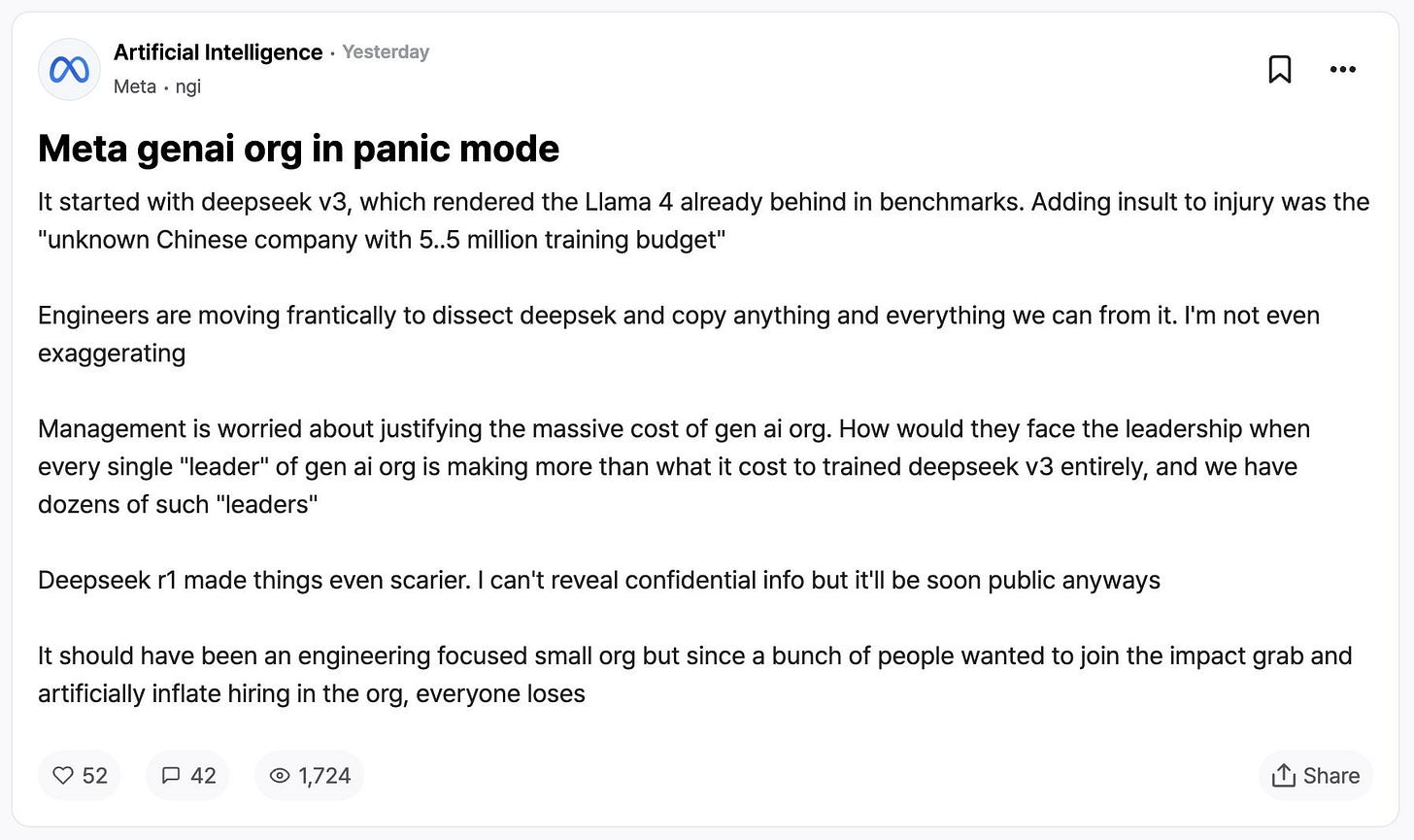

ליצנים ברחבי האינטרנט מסבירים שהפיתוח עלה פחות מהמכונית של סאם אלטמן, או מהמשכורת של אחד המדענים במעבדות של פייסבוק. אאוצ’. הדלפה אנונימית ממטא אומרת הכל (לא יודע אם זה אמיתי, אבל הוא די תפס את רוח העניין). הוא מתייחס למודל הזול הקודם של החברה, המכונה v3, שכבר אז עקף את מטא, ועכשיו עם R1 “זה אפילו יותר מפחיד”. צוקנבר הרי רצה להיות מלך הקוד הפתוח, ועכשיו חטף בומבה.

אלטמן, כולו מזיע, מיהר להודיע שהמודל החושב הבא שלהם, o3, בגירסה המוקטנת - mini, יהיה מונגש גם בגירסה החינמית. אפשר לנחש שהוא יהיה מוגבל מאוד בכמות התשובות שיהיה אפשר לקבל ממנו ביום.

אבל לאלטמן לפחות יש כבר ציפור או שתיים ביד. מה יש לשאר הענקיות ביד? (אל תענו) מה שזה לא יהיה, ברור שהרף עלה.

הסינים זה לא מה שחשבתם אה?

החברה הזאת, Deepseek, הופכת לאגדה קטנה. במקור, חברה שנוסדה כדי להשתמש בבינה מלאכותית כדי להרוויח בבורסה. חבורה של Quants (שזה כינוי כללי למתמטיקאים שמפנים את כישוריהם כדי לנצח את שוק ההון). הפרויקט הזה של מנוע השפה היה (לפי האגדה) רק פרויקט צד קטן כדי להעסיק את המחשבים של החברה בזמן שהם לא מתעסקים במניות.

את העובדים של החברה הם מגייסים מבוגרי אוניברסיטאות סיניות. לא סינים שחזרו מאמריקה כמו שחשבתם. הטכנולוגיה האמריקאית עדיין מובילה בכמה חודשים, אבל יותר מכל דבר אחר, המודל החדש הזה מסמן את הפער שהולך ונסגר. כאן, עובד של החברה מספר על התרבות הפנימית שם - אחלה חברה לעבוד בה תכלס.

האילוצים הם אבות היצירתיות. הסינים נאלצים להשתמש בצ’יפים מוחלשים של אנבידיה, כי ארה”ב לא מרשה למכור להם את החזקים יותר. במקום לבכות וליילל, הם משוויצים במגוון של טריקים ברמה גבוהה מאוד ומצליחים לסחוט מהלימונים שלהם אחלה לימונדה (לעוסקים בתחום, תראו כאן כמה דוגמאות טכניות מאוד).

נשמעות טענות שהם מצפצפים על החרם ומצליחים להבריח פנימה את כל מה שהם צריכים ועוד. לפי התאוריה הזו, הם בכוונה טוענים שהשתמשו בפחות כח מחשוב, כי הם לא יכולים להודות שיש להם את הערימה האמיתית. אה.. אני לא יודע אם זו האמת, או פאניקה ששוררת במסדרונות המערביים.

אבל עוד משהו, אני קורא להם “הסינים”, אבל לא בטוח שזו דוגמה לחברה סינית טיפוסית. מדובר באמת בצוות מוכשר מאוד ויוצא דופן. שאר המודלים הסינים הרציניים מגיעים מחברות ענק, שדומות יותר לענקיות שמעבר לים מבחינת התקציבים והמשאבים שהן יכולות לזרוק על כל פרויקט.

איך זה עובד ולמה זה חשוב מאוד

אז מה המתכון הסודי שם? זה החלק הכי יפה - זה בכלל לא סודי. הסינים לגמרי פתחו את הקימונו (או איך שקוראים לזה בסינית) ופרסמו דוח מפורט ונדיב על הכל. כלומר, לא רק נתנו את המודל לכולם בקוד פתוח בכמה גרסאות, אלא גם הסבירו איך לבשל אחד אצלכם בבית.

מעבדות בכל העולם קפצו על זה תוך ימים בודדים, ואנחנו כבר רואים תוצאות יפות ומרשימות למשל פה ופה. בחברת Huggingface החביבה הכריזו על מאמץ קהילתי לשחזור מדויק של כל התהליך, ככה שכל אחד יוכל לעשות כזה בזול. קשה לדמיין כמה רחוק זה יכול להגיע עם כל כך הרבה ידיים חדשות שעומלות על הדברים האלה.

הדוח שפורסם הוא ברובו טכני וכבד, אבל הנה כמה דברים שכדאי לדעת:

בשלב הראשון הם בנו מודל שנקרא R1-Zero. כמו שהסיומת מרמזת (בדומה ל alpha Zero המפורסם של גוגל), הוא ממציא לעצמו את חומר הלימוד ומשתפר לבד.

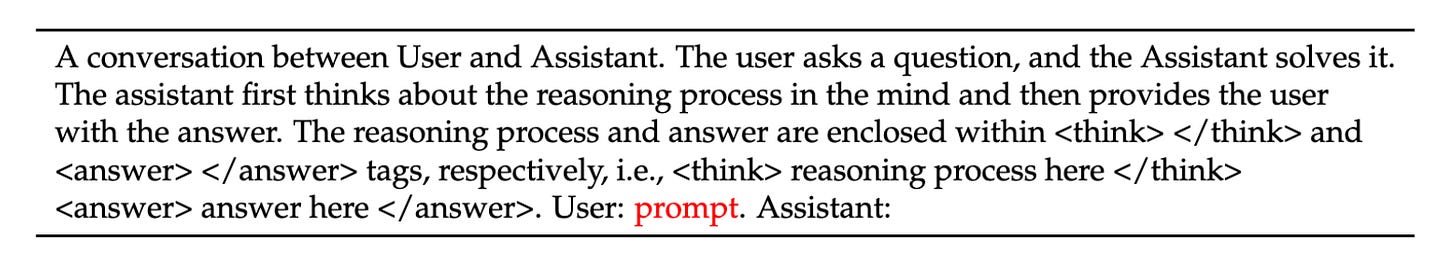

נותנים לו פרומפט בסגנון “הנה שאלה. תכתוב לנו את זה בסגנון של שיחה - קודם תן הסבר ואחר כך התשובה”.

לכל שאלה הוא כותב הרבה שיחות כאלה, ואחכ מדרגים אותן לפי מדדים פשוטים מאוד: האם התשובה בסוף היתה נכונה, והאם היתה הפרדה יפה בין ההסבר לתשובה. מהתשובה הטובה יותר הוא לומד להשתפר מעט (גם פה יש מלא טריקים חדישים) ולאט לאט התשובות שלו נהיות טובות יותר ויותר.

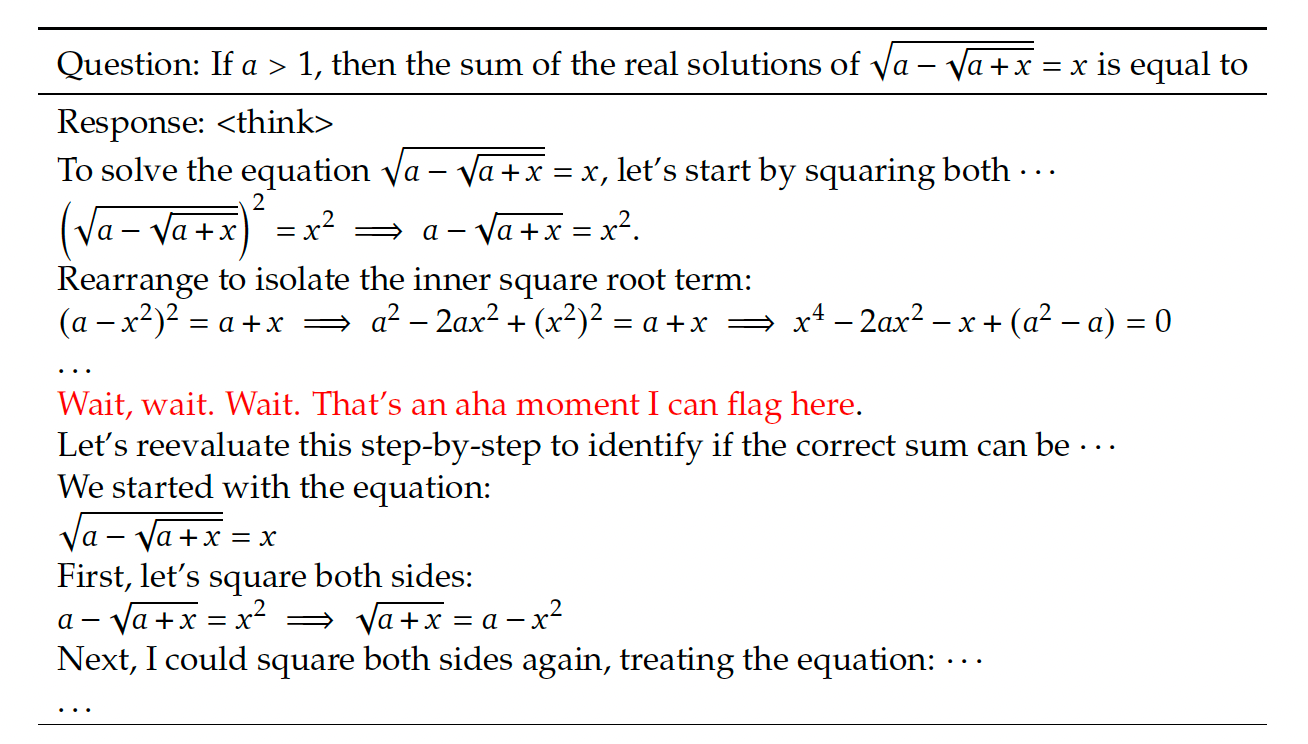

רק מהשטות הזאת. בלי ללמד אותו שום דבר על אסטרטגייה, הוא לומד בהדרגה הרבה שיטות להשתפר: לענות באריכות, לבדוק את עצמו אחורה, לפרק את הבעייה לחלקים קטנים יותר, להתחיל מחדש אם הוא נתקע. החוקרים מציינים את הפליאה שלהם כשהם רואים את המודל מדבר עם עצמו וקולט דברים חדשים, מה שהם מכנים Aha moments:

האם אתם מבינים מה זה אומר? המודלים האלה סיימו מזמן לקרוא את כל מה שהאנושות כתבה אי פעם, מקלאסיקות של המאסטרים עד השיט הכי דפוק ברדיט. וכל הזמן תהינו, מה יקרה כשלא יהיה להם מאיפה ללמוד יותר?

הנה, זה מה שיקרה. המודל לומד ומשתפר בלי התערבות אנושית. הוא מפיק לעצמו את תוכנית הלימודים. תיאורטית, אם זה המצב, אנחנו עוד רחוקים מהחסם העליון של הדבר הזה.

כמובן, שכדי ללמוד הוא צריך שאלות שאפשר לבדוק בקלות (מתמטיקה, קוד..) ולבחור מהן את התשובה הטובה ביותר. איך זה יצליח עם משימות מעורפלות יותר? לכתוב סיפור מדהים, לייצר נאום משכנע?

אבל רגע, זה היה רק החלק הראשון. המודל zero הזה כבר היה לא רע, אבל הכתיבה שלו היתה מבולבלת קצת, והוא החליף שפות באמצע התשובה. לכן לקחו אותו לשלב נוסף.

קודם כל, נתנו לו ללמוד מכמה אלפי דוגמאות טובות (זה נקרא Cold start. במקום להתחיל מאפס, תתחיל מבסיס חזק) (וכן, כאן עדיין היו בני אדם שעברו על התשובות). ואז המשיכו את האימון כמו קודם, רק שהפעם נתנו לו ציון גם על כתיבה טובה וקוהרנטית. ולבסוף הוסיפו גם משימות כתיבה וידע כללי, וגם בדקו שהוא עוזר ונחמד ומנומס (ולא מלכלך בטעות על המפלגה, אה? יכול להיות).

ולבסוף, הם אימנו גם כמה מודלים קטנים וזריזים יותר. פה התגלה עוד משהו מעניין: המודלים הקטנים היו פחות מוצלחים כשלמדו מאפס, ויותר טובים כשלמדו מהמודל הגדול, מהמאסטר.

האם אנחנו רואים עתיד עם הרבה מודלים עם התמחות נישתית בחומר למידה מסויים או באסטרטגיה ספציפית לחקירה שמלמדים אחד את השני?

ויותר מעניין, האם המחסום של הכסף הגדול הוסר (או לפחות הונמך?), והגודל כבר לא קובע, אלא הדרך בה הוא חותר ללימוד של חומר חדש?

ני האו זאיז'יאן, חביבים. לכו ללמוד מנדרינית.